mirror of

https://github.com/DominikDoom/a1111-sd-webui-tagcomplete.git

synced 2026-01-27 03:29:55 +00:00

Compare commits

38 Commits

| Author | SHA1 | Date | |

|---|---|---|---|

|

|

4a415f1a04 | ||

|

|

21de5fe003 | ||

|

|

a020df91b2 | ||

|

|

0260765b27 | ||

|

|

638c073f37 | ||

|

|

d11b53083b | ||

|

|

571072eea4 | ||

|

|

acfdbf1ed4 | ||

|

|

2e271aea5c | ||

|

|

b28497764f | ||

|

|

0d9d5f1e44 | ||

|

|

de3380818e | ||

|

|

acb85d7bb1 | ||

|

|

39ea33be9f | ||

|

|

1cac893e63 | ||

|

|

94823b871c | ||

|

|

599ff8a6f2 | ||

|

|

6893113e0b | ||

|

|

ed89d0e7e5 | ||

|

|

e47c14ab5e | ||

|

|

2ae512c8be | ||

|

|

4a427e309b | ||

|

|

510ee66b92 | ||

|

|

c41372143d | ||

|

|

f1d911834b | ||

|

|

40d9fc1079 | ||

|

|

88fa4398c8 | ||

|

|

3496fa58d9 | ||

|

|

737b697357 | ||

|

|

8523d7e9b5 | ||

|

|

77c0970500 | ||

|

|

707202ed71 | ||

|

|

922414b4ba | ||

|

|

7f18856321 | ||

|

|

cc1f35fc68 | ||

|

|

ae0f80ab0e | ||

|

|

8a436decf2 | ||

|

|

7357ccb347 |

58

README.md

58

README.md

@@ -42,7 +42,7 @@ You can install it using the inbuilt available extensions list, clone the files

|

||||

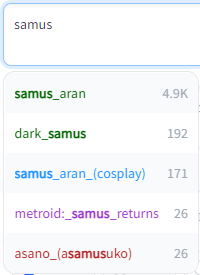

Tag autocomplete supports built-in completion for:

|

||||

- 🏷️ **Danbooru & e621 tags** (Top 100k by post count, as of November 2022)

|

||||

- ✳️ [**Wildcards**](#wildcards)

|

||||

- ➕ [**Extra network**](#extra-networks-embeddings-hypernets-lora) filenames, including

|

||||

- ➕ [**Extra network**](#extra-networks-embeddings-hypernets-lora-) filenames, including

|

||||

- Textual Inversion embeddings [(jump to readme section)]

|

||||

- Hypernetworks

|

||||

- LoRA

|

||||

@@ -123,6 +123,42 @@ Completion for these types is triggered by typing `<`. By default it will show t

|

||||

- Or `<lora:` and `<lyco:` respectively for the long form

|

||||

- `<h:` or `<hypernet:` will only show Hypernetworks

|

||||

|

||||

### Lora / Lyco trigger word completion

|

||||

This feature will try to add known trigger words on autocompleting a Lora/Lyco.

|

||||

|

||||

It primarily uses the list provided by the [model-keyword](https://github.com/mix1009/model-keyword/) extension, which thus needs to be installed to use this feature. The list is also regularly updated through it.

|

||||

However, once installed, you can deactivate it if you want, since tag autocomplete only needs the local keyword lists it ships with, not the extension itself.

|

||||

The used files are `lora-keyword.txt` and `lora-keyword-user.txt` in the model-keyword installation folder.

|

||||

If the main file isn't found, the feature will simply deactivate itself, everything else should work normally.

|

||||

|

||||

#### Note:

|

||||

As of [v1.5.0](https://github.com/AUTOMATIC1111/stable-diffusion-webui/commit/a3ddf464a2ed24c999f67ddfef7969f8291567be), the webui provides a native method to add activation keywords for Lora through the Extra networks config UI.

|

||||

These trigger words will always be preferred over the model-keyword ones and can be used without needing to install the model-keyword extension. This will however, obviously, be limited to those manually added keywords. For automatic discovery of keywords, you will still need the big list provided by model-keyword.

|

||||

|

||||

Custom trigger words can be added through two methods:

|

||||

1. Using the extra networks UI (recommended):

|

||||

- Only works with webui version v1.5.0 upwards, but much easier to use and works without the model-keyword extension

|

||||

- This method requires no manual refresh

|

||||

- <details>

|

||||

<summary>Image example</summary>

|

||||

|

||||

|

||||

|

||||

</details>

|

||||

2. Through the model-keyword UI:

|

||||

- One issue with this method is that it has no official support for the Lycoris extension and doesn't scan its folder for files, so to add them through the UI you will have to temporarily move them into the Lora model folder to be able to select them in model-keywords dropdown. Some are already included in the default list though, so trying it out first is advisable.

|

||||

- After having added your custom keywords, you will need to either restart the UI or use the "Refresh TAC temp files" setting button.

|

||||

- <details>

|

||||

<summary>Image example</summary>

|

||||

|

||||

|

||||

</details>

|

||||

|

||||

Sometimes the inserted keywords can be wrong due to a hash collision, however model-keyword and tag autocomplete take the name of the file into account too if the collision is known.

|

||||

|

||||

If it still inserts something wrong or you simply don't want the keywords added that time, you can undo / redo it directly after as often as you want, until you type something else

|

||||

(It uses the default undo/redo action of the browser, so <kbd>CTRL</kbd> + <kbd>Z</kbd>, context menu and mouse macros should all work).

|

||||

|

||||

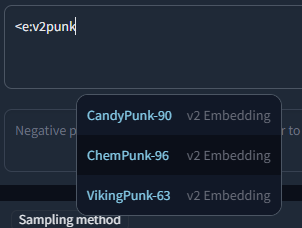

### Embedding type filtering

|

||||

Embeddings trained for Stable Diffusion 1.x or 2.x models respectively are incompatible with the other type. To make it easier to find valid embeds, they are categorized by "v1 Embedding" and "v2 Embedding", including a slight color difference. You can also filter your search to include only v1 or v2 embeddings by typing `<v1/2` or `<e:v1/2` followed by the actual search term.

|

||||

|

||||

@@ -285,6 +321,26 @@ Depending on the last setting, tag autocomplete will append a comma and space af

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Lora keywords -->

|

||||

<details>

|

||||

<summary>Lora / Lyco trigger word insertion</summary>

|

||||

|

||||

See [the detailed readme section](#lora--lyco-trigger-word-completion) for more info.

|

||||

|

||||

Selects the mode to use for Lora / Lyco trigger word insertion.

|

||||

Needs the [model-keyword](https://github.com/mix1009/model-keyword/) extension to be installed, else it will do nothing.

|

||||

|

||||

- Never

|

||||

- Will not complete trigger words, even if the model-keyword extension is installed

|

||||

- Only user list

|

||||

- Will only load the custom keywords specified in the lora-keyword-user.txt file and ignore the default list

|

||||

- Always

|

||||

- Will load and use both lists

|

||||

|

||||

Switching from "Never" to what you had before or back will not require a restart, but changing between the full and user only list will.

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Wildcard path mode -->

|

||||

<details>

|

||||

<summary>Wildcard path completion</summary>

|

||||

|

||||

428

README_JA.md

428

README_JA.md

@@ -1,21 +1,67 @@

|

||||

|

||||

|

||||

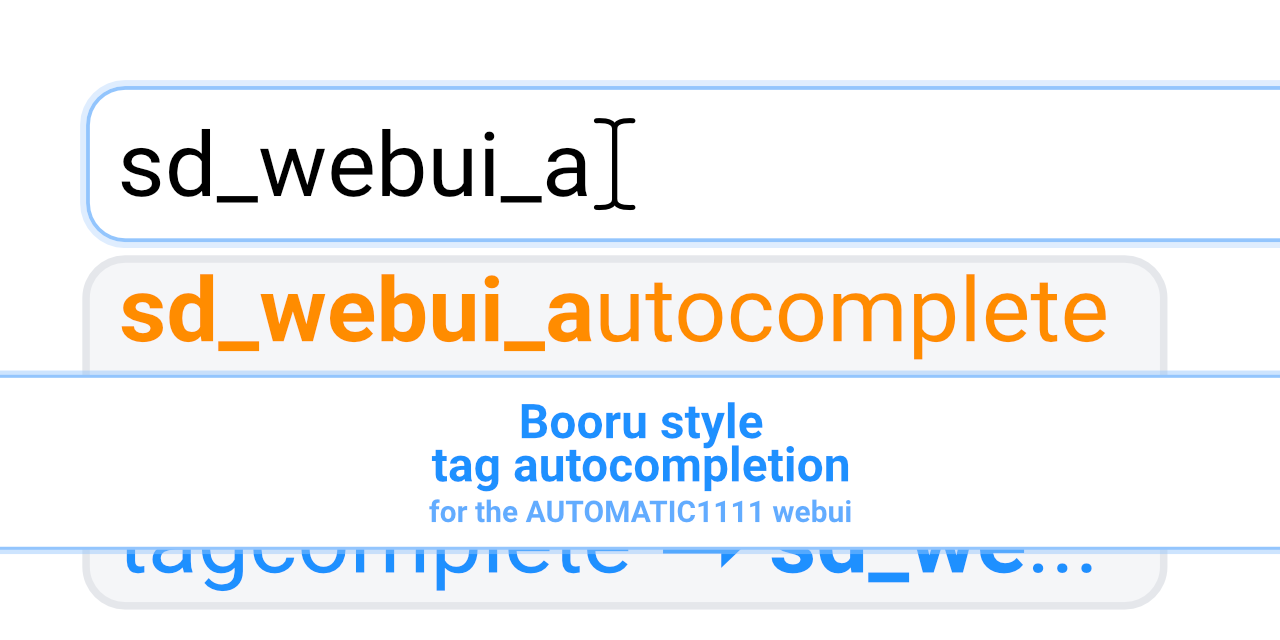

# Booru tag autocompletion for A1111

|

||||

<div align="center">

|

||||

|

||||

[](https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/releases)

|

||||

# SD WebUI Tag Autocomplete

|

||||

## [English Document](./README.md), [中文文档](./README_ZH.md), 日本語

|

||||

|

||||

## [English Document](./README.md), [中文文档](./README_ZH.md)

|

||||

Booruスタイルタグを自動補完するためのAUTOMATIC1111 Stable Diffusion WebUI用拡張機能

|

||||

|

||||

このカスタムスクリプトは、Stable Diffusion向けの人気のweb UIである、[AUTOMATIC1111 web UI](https://github.com/AUTOMATIC1111/stable-diffusion-webui)の拡張機能として利用できます。

|

||||

[![Github Release][release-shield]][release-url]

|

||||

[![stargazers][stargazers-shield]][stargazers-url]

|

||||

[![contributors][contributors-shield]][contributors-url]

|

||||

[![forks][forks-shield]][forks-url]

|

||||

[![issues][issues-shield]][issues-url]

|

||||

|

||||

[変更内容][release-url] •

|

||||

[確認されている問題](#%EF%B8%8F-よくある問題また現在確認されている問題) •

|

||||

[バグを報告する][issues-url] •

|

||||

[機能追加に関する要望][issues-url]

|

||||

</div>

|

||||

<br/>

|

||||

|

||||

# 📄 説明

|

||||

|

||||

Tag AutocompleteはStable Diffusion向けの人気のweb UIである、[AUTOMATIC1111 web UI](https://github.com/AUTOMATIC1111/stable-diffusion-webui)の拡張機能として利用できます。

|

||||

|

||||

主にアニメ系イラストを閲覧するための掲示板「Danbooru」などで利用されているタグの自動補完ヒントを表示するための拡張機能となります。

|

||||

[Waifu Diffusion](https://github.com/harubaru/waifu-diffusion)など、この情報を使って学習させたStable Diffusionモデルもあるため、正確なタグをプロンプトに使用することで、構図を改善し、思い通りの画像が生成できるようになります。

|

||||

例えば[Waifu Diffusion](https://github.com/harubaru/waifu-diffusion)やNAIから派生した多くのモデルやマージなど、Stable Diffusionモデルの中にはこの情報を使って学習されたものもあるため、プロンプトに正確なタグを使用することで、多くのケースで構図を改善した思い通りの画像が生成できるようになります。

|

||||

|

||||

web UIに内蔵されている利用可能な拡張機能リストを使用してインストールするか、[以下の説明](#インストール)に従ってファイルを手動でcloneするか、または[リリース](https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/releases)からパッケージ化されたバージョンを使用することができます。

|

||||

組み込みの利用可能な拡張機能リストを使ってインストールしたり、[下記](#-インストール)の説明に従って手動でファイルをcloneしたり、[Releases](https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/releases)にあるパッケージ済みのバージョンを使うことができます。

|

||||

|

||||

## よく発生する問題 & 発見されている課題:

|

||||

- ブラウザの設定によっては、古いバージョンのスクリプトがキャッシュされていることがあります。アップデート後に新機能が表示されない場合などには、`CTRL+F5`でキャッシュを利用せずにサイトを強制的にリロードしてみてください。

|

||||

- プロンプトのポップアップのスタイルが崩れていたり、全く表示されない場合([このような場合](https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/assets/34448969/7bbfdd54-fc23-4bfc-85af-24704b139b3a))、openpose-editor拡張機能をインストールしている場合は、必ずアップデートしてください。古いバージョンでは、他の拡張機能との間で問題が発生することが知られています。

|

||||

<br/>

|

||||

|

||||

# ✨ Features

|

||||

- 🚀 タイピング中に補完のためのヒントを表示 (通常時)

|

||||

- ⌨️ キーボードナビゲーション

|

||||

- 🌒 ダーク&ライトモードのサポート

|

||||

- 🛠️ 多くの[設定](#%EF%B8%8F-設定)とカスタマイズ性を提供

|

||||

- 🌍 [翻訳サポート](#翻訳)タグ、オプションでプロンプトのライブ プレビュー付き

|

||||

- 私が知っている翻訳のリストは[こちら](#翻訳リスト)を参照してください。

|

||||

|

||||

タグの自動補完は組み込まれている補完内容をサポートしています:

|

||||

- 🏷️ **Danbooru & e621 tags** (投稿数上位100k、2022年11月現在)

|

||||

- ✳️ [**ワイルドカード**](#ワイルドカード)

|

||||

- ➕ [**Extra networks**](#extra-networks-embeddings-hypernets-lora-) filenames, including

|

||||

- Textual Inversion embeddings

|

||||

- Hypernetworks

|

||||

- LoRA

|

||||

- LyCORIS / LoHA

|

||||

- 🪄 [**Chants(詠唱)**](#chants詠唱) (長いプロンプトプリセット用のカスタムフォーマット)

|

||||

- 🏷️ "[**Extra file**](#extra-file)", カスタマイズ可能なextra tagsセット

|

||||

|

||||

|

||||

さらに、サードパーティの拡張機能にも対応しています:

|

||||

<details>

|

||||

<summary>クリックして開く</summary>

|

||||

|

||||

- [Image Browser][image-browser-url] - ファイル名とEXIFキーワードによる検索

|

||||

- [Multidiffusion Upscaler][multidiffusion-url] - 地域別のプロンプト

|

||||

- [Dataset Tag Editor][tag-editor-url] - キャプション, 結果の確認, タグの編集 & キャプションの編集

|

||||

- [WD 1.4 Tagger][wd-tagger-url] - 追加と除外タグ

|

||||

- [Umi AI][umi-url] - YAMLワイルドカードの補完

|

||||

</details>

|

||||

<br/>

|

||||

|

||||

## スクリーンショット & デモ動画

|

||||

<details>

|

||||

@@ -34,8 +80,8 @@ https://user-images.githubusercontent.com/34448969/200128031-22dd7c33-71d1-464f-

|

||||

|

||||

</details>

|

||||

|

||||

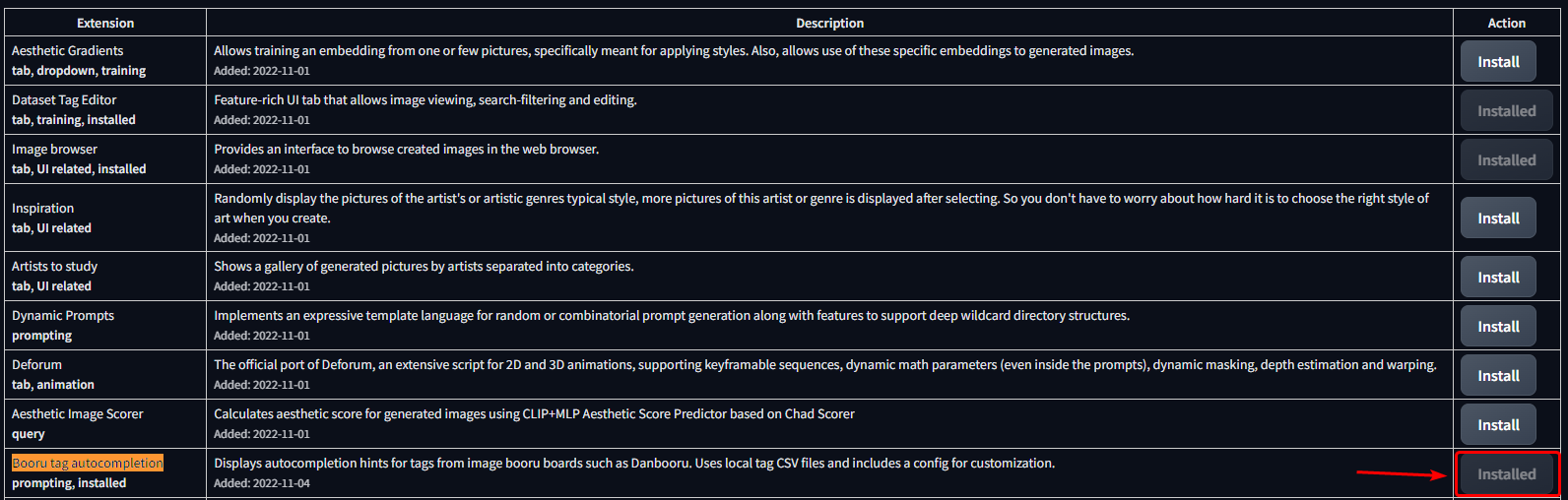

## インストール

|

||||

### 内蔵されている拡張機能リストを用いた方法

|

||||

# 📦 インストール

|

||||

## 内蔵されている拡張機能リストを用いた方法

|

||||

1. Extensions タブを開く

|

||||

2. Available タブを開く

|

||||

3. "Load from:" をクリック

|

||||

@@ -48,14 +94,14 @@ https://user-images.githubusercontent.com/34448969/200128031-22dd7c33-71d1-464f-

|

||||

|

||||

|

||||

|

||||

### 手動でcloneする方法

|

||||

## 手動でcloneする方法

|

||||

```bash

|

||||

git clone "https://github.com/DominikDoom/a1111-sd-webui-tagcomplete.git" extensions/tag-autocomplete

|

||||

```

|

||||

(第2引数でフォルダ名を指定可能なので、好きな名前を指定しても良いでしょう)

|

||||

|

||||

## 追加で有効化できる補完機能

|

||||

### ワイルドカード

|

||||

# ❇️ 追加で有効化できる補完機能

|

||||

## ワイルドカード

|

||||

|

||||

自動補完は、https://github.com/AUTOMATIC1111/stable-diffusion-webui-wildcards 、または他の類似のスクリプト/拡張機能で使用されるワイルドカードファイルでも利用可能です。補完は `__` (ダブルアンダースコア) と入力することで開始されます。最初にワイルドカードファイルのリストが表示され、1つを選択すると、そのファイル内の置換オプションが表示されます。

|

||||

これにより、スクリプトによって置換されるカテゴリを挿入するか、または直接1つを選択して、ワイルドカードをカテゴリ化されたカスタムタグシステムのようなものとして使用することができます。

|

||||

@@ -66,20 +112,21 @@ git clone "https://github.com/DominikDoom/a1111-sd-webui-tagcomplete.git" extens

|

||||

|

||||

ワイルドカードはすべての拡張機能フォルダと、古いバージョンをサポートするための `scripts/wildcards` フォルダで検索されます。これは複数の拡張機能からワイルドカードを組み合わせることができることを意味しています。ワイルドカードをグループ化した場合、ネストされたフォルダもサポートされます。

|

||||

|

||||

### Embeddings, Lora & Hypernets

|

||||

## Extra networks (Embeddings, Hypernets, LoRA, ...)

|

||||

これら3つのタイプの補完は、`<`と入力することで行われます。デフォルトでは3つとも混在して表示されますが、以下の方法でさらにフィルタリングを行うことができます:

|

||||

- `<e:` は、embeddingsのみを表示します。

|

||||

- `<l:` 、または `<lora:` はLoraのみを表示します。

|

||||

- `<l:` は、LoRAとLyCORISのみを表示します。

|

||||

- または `<lora:` と `<lyco:` で入力することも可能です

|

||||

- `<h:` 、または `<hypernet:` はHypernetworksのみを表示します

|

||||

|

||||

#### Embedding type filtering

|

||||

### Embedding type filtering

|

||||

Stable Diffusion 1.xまたは2.xモデル用にそれぞれトレーニングされたembeddingsは、他のタイプとの互換性がありません。有効なembeddingsを見つけやすくするため、若干の色の違いも含めて「v1 Embedding」と「v2 Embedding」で分類しています。また、`<v1/2`または`<e:v1/2`に続けて実際の検索のためのキーワードを入力すると、v1またはv2embeddingsのみを含むように検索を絞り込むことができます。

|

||||

|

||||

例:

|

||||

|

||||

|

||||

|

||||

### Chants(詠唱)

|

||||

## Chants(詠唱)

|

||||

Chants(詠唱)は、より長いプロンプトプリセットです。この名前は、中国のユーザーによる初期のプロンプト集からヒントを得たもので、しばしば「呪文書」(原文は「Spellbook」「Codex」)などと呼ばれていました。

|

||||

このような文書から得られるプロンプトのスニペットは、このような理由から呪文や詠唱と呼ばれるにふさわしいものでした。

|

||||

|

||||

@@ -89,8 +136,11 @@ EmbeddingsやLoraと同様に、この機能は `<`, `<c:`, `<chant:` コマン

|

||||

(masterpiece, best quality, high quality, highres, ultra-detailed),

|

||||

```

|

||||

|

||||

|

||||

Chants(詠唱)は、以下のフォーマットに従ってJSONファイルで追加することができます::

|

||||

|

||||

<details>

|

||||

<summary>Chant format (click to expand)</summary>

|

||||

|

||||

```json

|

||||

[

|

||||

{

|

||||

@@ -113,6 +163,10 @@ Chants(詠唱)は、以下のフォーマットに従ってJSONファイル

|

||||

}

|

||||

]

|

||||

```

|

||||

|

||||

</details>

|

||||

<br/>

|

||||

|

||||

このファイルが拡張機能の `tags` フォルダ内にある場合、settings内の"Chant file"ドロップダウンから選択することができます。

|

||||

|

||||

chantオブジェクトは4つのフィールドを持ちます:

|

||||

@@ -121,7 +175,7 @@ chantオブジェクトは4つのフィールドを持ちます:

|

||||

- `content` - 実際に挿入されるプロンプト

|

||||

- `color` - 表示される色。通常のタグと同じカテゴリーカラーシステムを使用しています。

|

||||

|

||||

### Umi AI tags

|

||||

## Umi AI tags

|

||||

https://github.com/Klokinator/Umi-AI は、Unprompted や Dynamic Wildcards に似た、機能豊富なワイルドカード拡張です。

|

||||

例えば `<[preset][--female][sfw][species]>` はプリセットカテゴリーを選び、女性関連のタグを除外し、さらに次のカテゴリーで絞り込み、実行時にこれらすべての条件に一致するランダムなフィルインを1つ選び出します。補完は `<[`] とそれに続く新しい開く括弧、例えば `<[xyz][`] で始まり、 `>` で閉じるまで続きます。

|

||||

|

||||

@@ -130,78 +184,263 @@ https://github.com/Klokinator/Umi-AI は、Unprompted や Dynamic Wildcards に

|

||||

|

||||

ほとんどの功績は[@ctwrs](https://github.com/ctwrs)によるものです。この方はUmiの開発者の一人として多くの貢献をしています。

|

||||

|

||||

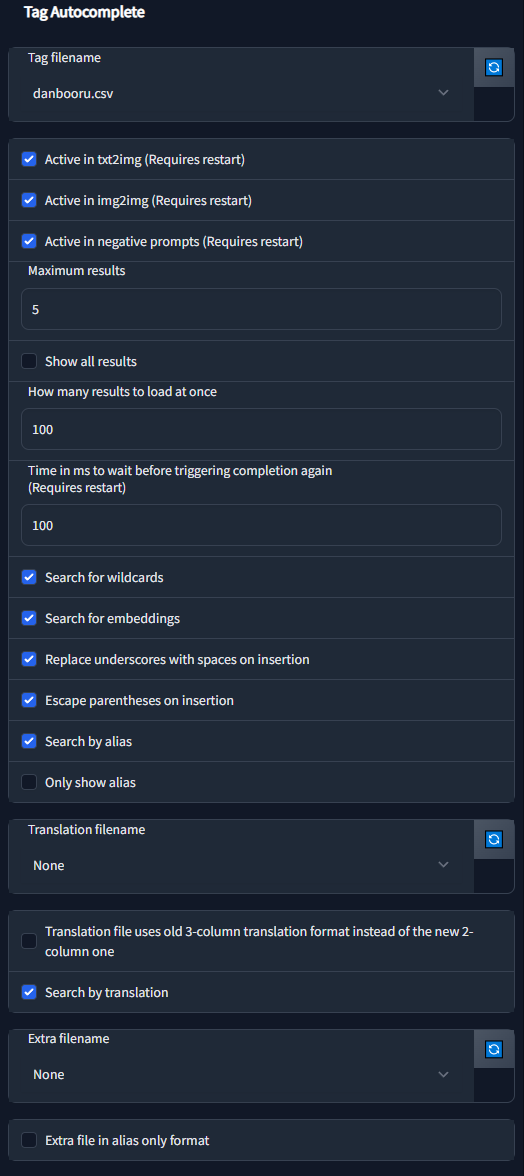

## Settings

|

||||

# 🛠️ 設定

|

||||

|

||||

この拡張機能には、大量の設定&カスタマイズ性が組み込まれています:

|

||||

この拡張機能には多くの設定とカスタマイズ機能が組み込まれています。ほとんどのことははっきりしていますが、詳細な説明は以下のセクションをクリックしてください。

|

||||

|

||||

|

||||

<!-- Filename -->

|

||||

<details>

|

||||

<summary>Tag filename</summary>

|

||||

|

||||

| 設定項目 | 説明 |

|

||||

|---------|-------------|

|

||||

| tagFile | 使用するタグファイルを指定します。お好みのタグデータベースを用意することができますが、このスクリプトはDanbooruタグを想定して開発されているため、他の構成では正常に動作しない場合があります。|

|

||||

| activeIn | txt2img、img2img、またはその両方のネガティブプロンプトのスクリプトを有効、または無効にすることができます。 |

|

||||

| maxResults | 最大何件の結果を表示するか。デフォルトのタグセットでは、結果は出現回数順に表示されます。embeddingsとワイルドカードの場合は、スクロール可能なリストですべての結果を表示します。 |

|

||||

| resultStepLength | 長いリストやshowAllResultsがtrueの場合に、指定したサイズの小さなバッチで結果を読み込むことができるようにします。 |

|

||||

| delayTime | オートコンプリートを起動するまでの待ち時間をミリ秒単位で指定できます。これは入力中に頻繁に補完内容が更新されるのを防ぐのに役立ちます。 |

|

||||

| showAllResults | trueの場合、maxResultsを無視し、すべての結果をスクロール可能なリストで表示します。**警告:** 長いリストの場合、ブラウザが遅くなることがあります。 |

|

||||

| replaceUnderscores | trueにした場合、タグをクリックしたときに `_`(アンダースコア)が ` `(スペース)に置き換えられます。モデルによっては便利になるかもしれません。 |

|

||||

| escapeParentheses | trueの場合、()を含むタグをエスケープして、Web UIのプロンプトの重み付け機能に影響を与えないようにします。 |

|

||||

| appendComma | UIスイッチ "Append commas"の開始される値を指定することができます。UIのオプションが無効の場合、常にこの値が使用されます。 |

|

||||

| useWildcards | ワイルドカード補完機能の切り替えに使用します。 |

|

||||

| useEmbeddings | embedding補完機能の切り替えに使用します。 |

|

||||

| alias | エイリアスに関するオプションです。詳しくは下のセクションをご覧ください。 |

|

||||

| translation | 翻訳用のオプションです。詳しくは下のセクションをご覧ください。 |

|

||||

| extras | タグファイル/エイリアス/翻訳を追加するためのオプションです。詳しくは下記をご覧ください。 |

|

||||

| chantFile | chants(長いプロンプト・プリセット/ショートカット)に使用するためファイルです。 |

|

||||

| keymap | カスタマイズ可能なhotkeyを設定するために利用します。 |

|

||||

| colors | タグの色をカスタマイズできます。詳しくは下記をご覧ください。 |

|

||||

### Colors

|

||||

タグタイプに関する色は、タグ自動補完設定のためのJSONコードを変更することで指定することができます。

|

||||

フォーマットは標準的なJSONで、オブジェクト名は、それらが使用されるタグのファイル名(.csvを除く)に対応しています。

|

||||

角括弧の中の最初の値はダークモード、2番目の値はライトモードです。色の名称と16進数、どちらも使えるはずです。

|

||||

スクリプトが使用するメインのタグファイルとなります。デフォルトでは `danbooru.csv` と `e621.csv` が含まれており、ここにカスタムタグを追加することもできますが、大半のモデルはこの2つ以外(主にdanbooru)では学習していないため、あまり意味はありません。

|

||||

|

||||

```json

|

||||

{

|

||||

"danbooru": {

|

||||

"-1": ["red", "maroon"],

|

||||

"0": ["lightblue", "dodgerblue"],

|

||||

"1": ["indianred", "firebrick"],

|

||||

"3": ["violet", "darkorchid"],

|

||||

"4": ["lightgreen", "darkgreen"],

|

||||

"5": ["orange", "darkorange"]

|

||||

},

|

||||

"e621": {

|

||||

"-1": ["red", "maroon"],

|

||||

"0": ["lightblue", "dodgerblue"],

|

||||

"1": ["gold", "goldenrod"],

|

||||

"3": ["violet", "darkorchid"],

|

||||

"4": ["lightgreen", "darkgreen"],

|

||||

"5": ["tomato", "darksalmon"],

|

||||

"6": ["red", "maroon"],

|

||||

"7": ["whitesmoke", "black"],

|

||||

"8": ["seagreen", "darkseagreen"]

|

||||

}

|

||||

}

|

||||

```

|

||||

また、カスタムタグファイルの新しいカラーセットを追加する際にも使用できます。

|

||||

数字はタグの種類を指定するもので、タグのソースに依存します。例として、[CSV tag data](#csv-tag-data)を参照してください。

|

||||

拡張機能の他の機能(ワイルドカードやLoRA補完など)を使いたいが、通常のタグには興味がない場合は、`None`に設定することも可能です。

|

||||

|

||||

### エイリアス, 翻訳 & Extra tagsについて

|

||||

#### エイリアス

|

||||

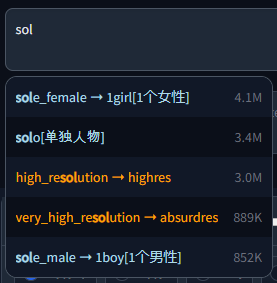

Booruのサイトのように、タグは1つまたは複数のエイリアスを持つことができ、完了時に実際の値へリダイレクトされて入力されます。これらは `config.json` の設定をもとに検索/表示されます:

|

||||

- `searchByAlias` - エイリアスも検索対象とするか、実際のタグのみを検索対象とするかを設定します

|

||||

- `onlyShowAlias` - `alias -> actual` の代わりに、エイリアスのみを表示します。表示のみで、最後に挿入されるテキストは実際のタグのままです。

|

||||

|

||||

</details>

|

||||

|

||||

#### 翻訳

|

||||

<!-- Active In -->

|

||||

<details>

|

||||

<summary>"Active in" の設定</summary>

|

||||

|

||||

タグのオートコンプリートがどこにアタッチされ、変更を受け付けるかを指定します。

|

||||

ネガティブプロンプトはtxt2imgとimg2imgの設定に従うので、"親 "がアクティブな場合にのみアクティブとなります。

|

||||

|

||||

|

||||

</details>

|

||||

|

||||

<!-- Blacklist -->

|

||||

<details>

|

||||

<summary>Black / Whitelist</summary>

|

||||

|

||||

このオプションは、タグのオートコンプリートをグローバルにオフにすることができますが、特定のモデルに対してのみ有効または無効にしたい場合もあります。

|

||||

例えば、あなたのモデルのほとんどがアニメモデルである場合、boorタグでトレーニングされておらず、その恩恵を受けないフォトリアリスティックモデルをブラックリストに追加し、これらのモデルに切り替えた後に自動的に無効にすることができます。モデル名(拡張子を含む)とwebuiハッシュ(短い形式と長い形式の両方)の両方を使用できます。

|

||||

|

||||

`Blacklist`は指定したすべてのモデルを除外しますが、`Whitelist`はこれらのモデルに対してのみ有効で、デフォルトではオフのままです。例外として、空のホワイトリストは無視されます(空のブラックリストと同じです)。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Move Popup -->

|

||||

<details>

|

||||

<summary>カーソルで補完ポップアップを移動</summary>

|

||||

|

||||

このオプションは、IDEで行われるような、カーソルの位置に追従するフローティングポップアップを有効または無効にします。スクリプトはポップアップが右側でつぶれないように十分なスペースを確保しようとしますが、長いタグでは必ずしもうまくいきません。無効にした場合、ポップアップは左側に表示されます。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Results Count -->

|

||||

<details>

|

||||

<summary>結果の数</summary>

|

||||

|

||||

一度に表示する結果の量を設定できます。

|

||||

`Show all results`が有効な場合、`Maximum results`で指定された数で切り捨てられるのではなく、スクロール可能なリストが表示されます。パフォーマンス上の理由から、この場合はすべてを一度に読み込むのではなく、ブロック単位で読み込みます。ブロックの大きさは`How many results to load at once`によって決まります。一番下に到達すると、次のブロックがロードされます(しかし、そんなことはめったには起こらないと思います)。

|

||||

|

||||

特筆すべきこととして、`Show all results` が使用される場合でも、`Maximum results` は影響を及ぼします。これは、スクロールが開始される前のポップアップの高さを制限するからです。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Delay time -->

|

||||

<details>

|

||||

<summary>補完の遅れについて</summary>

|

||||

|

||||

設定によっては、リアルタイムのタグ補完は計算量が多くなることがあります。

|

||||

このオプションは debounce による遅延をミリ秒単位で設定します(1000ミリ秒 = 1秒)。このオプションは、入力が非常に速い場合に特に有効です。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Search for -->

|

||||

<details>

|

||||

<summary>"Search for" に関する設定</summary>

|

||||

|

||||

特定の補完タイプを有効または無効にします。

|

||||

|

||||

Umi AIワイルドカードは、使用目的が似ているため、異なるフォーマットを使用しますが、ここでは通常のワイルドカードオプションに含まれます。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Wiki links -->

|

||||

<details>

|

||||

<summary>"?" Wiki links</summary>

|

||||

|

||||

このオプションがオンになっている場合、タグの横に `?` リンクが表示されます。これをクリックすると、danbooruまたはe621のそのタグのWikiページを開こうとします。

|

||||

|

||||

> ⚠️ 警告:

|

||||

>

|

||||

> Danbooruとe621は外部サイトであり、多くのNSFWコンテンツを含んでいます。このため、このオプションはデフォルトで無効になっています。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Insertion -->

|

||||

<details>

|

||||

<summary>補完設定</summary>

|

||||

|

||||

これらの設定で、テキストの挿入方法を指定できます。

|

||||

|

||||

Booruのサイトでは、タグにスペースの代わりにアンダースコアを使用することがほとんどですが、Stable diffusionで使用されているCLIPエンコーダーは自然言語でトレーニングされているため、前処理中にほとんどのモデルがこのアンダースコアをスペースに置き換えました。したがって、デフォルトではタグのオートコンプリートも同じようになります。

|

||||

|

||||

括弧は、プロンプトの特定の部分をより注目/重視するために、Webuiの制御文字として使用されるため、デフォルトでは括弧を含むタグはエスケープされます (`\( \)`) 。

|

||||

|

||||

最後の設定によりますが、タグのオートコンプリートはタグを挿入した後にカンマとスペースを追加します。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Wildcard path mode -->

|

||||

<details>

|

||||

<summary>ワイルドカードのパス補完</summary>

|

||||

|

||||

ワイルドカードのいくつかのコレクションは、ネストしたサブフォルダに整理されています。

|

||||

それらは、"hair/colors/light/... " や "clothing/male/casual/... " などのように、ファイルへのフルパスとともにリストアップされています。

|

||||

|

||||

このような場合、手動でフルパスを入力するのは難しいことが多いのですが、それでもリストをさらにスクロールする前に選択範囲を狭めたいものです。

|

||||

この場合、選択する結果がすべてのパスであれば、<kbd>Tab</kbd>(または`ChooseSelectedOrFirst`のカスタムホットキー)でパスの部分補完をトリガーすることが可能です。

|

||||

|

||||

この設定は、補完に使用するモードを決定します:

|

||||

- 次のフォルダレベルまで:

|

||||

- パス内の次の/まで補完し、選択したものを進む方向として優先します

|

||||

- オプションを直接選択したい場合は、<kbd>Enter</kbd> キーまたは `ChooseSelected` ホットキーを使用してスキップし、完全に補完します。

|

||||

- 最初の差分まで:

|

||||

- 結果内の最初の違いまで補完し、追加の情報を待ちます

|

||||

- 例:"/sub/folder_a/..." と "/sub/folder_b/..." がある場合、"su" と入力した後に補完すると、"/sub/folder_" まですべてを挿入し、a または b を入力して明確にするまでそこで停止します。

|

||||

- 矢印キーで何かを選択した場合(EnterキーやTabキーを押すかどうかに関係なく)、それをスキップして完全に補完します。

|

||||

- 常に全て:

|

||||

- 名前が示すように、部分的な補完動作を無効にし、通常のタグのようにすべての状況下で完全なパスを挿入します。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Alias -->

|

||||

<details>

|

||||

<summary>Alias 設定</summary>

|

||||

|

||||

タグはしばしば複数の別名(Alias)で参照されます。`Search by alias`がオンになっている場合、それらは検索結果に含まれ、正しいタグがわからない場合に役立ちます。この場合でも、挿入時にリンクされている実際のタグに置き換えられます。

|

||||

|

||||

`Only show alias` セットは、エイリアスのみを表示したい場合、またはそのエイリアスがマップするタグも表示したい場合に使用します。

|

||||

(`<alias> ➝ <actual>`として表示されます)

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Translations -->

|

||||

<details>

|

||||

<summary>翻訳設定</summary>

|

||||

|

||||

Tag Autocompleteは、別のファイル(`Translation filename`)で指定されたタグの翻訳をサポートしています。つまり、英語のタグ名が分からなくても、自身の言語の翻訳ファイルがあれば、それを代わりに使うことができます。

|

||||

|

||||

また、コミュニティで使用されている古いファイルのためのレガシーフォーマットオプションや、プロンプト全体のライブ翻訳プレビューなど実験的な機能もあります。

|

||||

|

||||

詳細については、以下の [翻訳に関するセクション](#翻訳) を参照してください。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Extra file -->

|

||||

<details>

|

||||

<summary>Extra ファイル設定</summary>

|

||||

|

||||

ここで指定したように、通常の結果の前後に追加される追加タグのセットを指定します。一般的に使用される品質タグ (`masterpiece, best quality,` など) のような小さなカスタムタグセットに便利です。

|

||||

|

||||

長いプリセットやプロンプト全体を補完したい場合は、代わりに [Chants(詠唱)](#chants詠唱) を参照してください。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Chants -->

|

||||

<details>

|

||||

<summary>Chant ファイル名</summary>

|

||||

|

||||

Chantとは、長いプリセット、あるいはプロンプト全体を一度に選択して挿入できるもので、Webuiに内蔵されているスタイルのドロップダウンに似ています。Chantにはいくつかの追加機能があり、より速く使用することができます。

|

||||

|

||||

詳しくは上記の[Chants(詠唱)](#chants詠唱)のセクションを参照してください。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Hotkeys -->

|

||||

<details>

|

||||

<summary>Hotkeys</summary>

|

||||

|

||||

ほとんどのキーボードナビゲーション機能のホットキーをここで指定できます。

|

||||

https://www.w3.org/TR/uievents-key/#named-key-attribute-value

|

||||

|

||||

機能の説明

|

||||

- Move Up / Down:次のタグを選択

|

||||

- Jump Up / Down:一度に5箇所移動する。

|

||||

- Jump to Start / End: リストの先頭または末尾にジャンプ

|

||||

- ChooseSelected ハイライトされたタグを選択するか、何も選択されていない場合はポップアップを閉じます。

|

||||

- ChooseSelectedOrFirst:上記と同じですが、何も選択されていない場合、デフォルトで最初の結果が選択されます。

|

||||

- Close ポップアップを閉じる

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Colors -->

|

||||

<details>

|

||||

<summary>Colors</summary>

|

||||

|

||||

ここでは、異なるタグカテゴリーに使用されるデフォルトの色を変更することができます。これらは、ソースサイトのカテゴリの色に似ているように選択されています。

|

||||

|

||||

フォーマットは標準的なJSON

|

||||

- オブジェクト名は、タグのファイル名に対応しています。

|

||||

- 数字はタグの種類を表し、タグのソースに依存します。詳細については、[CSV tag data](#csv-tag-data)を参照してください。

|

||||

- 角括弧内の最初の値はダークモード、2番目の値はライトモードです。HTMLの色名と16進数コードのどちらでも使えます。

|

||||

|

||||

これは、カスタムタグ・ファイルに新しいカラーセットを追加するためにも使用できます。

|

||||

|

||||

|

||||

</details>

|

||||

<!-- Temp files refresh -->

|

||||

<details>

|

||||

<summary>TACの一時作成ファイルのリフレッシュ</summary>

|

||||

|

||||

これは "フェイク"設定で、実際には何も設定しません。むしろ、開発者がwebuiのオプションに追加できる更新ボタンを悪用するための小さなハックです。この設定の隣にある更新ボタンをクリックすると、タグオートコンプリートにいくつかの一時的な内部ファイルを再作成・再読み込みさせます。

|

||||

|

||||

タグオートコンプリートは様々な機能、特に余分なネットワークとワイルドカード補完に関連するこれらのファイルに依存しています。この設定は、例えば新しいLoRAをいくつかフォルダに追加し、タグ・オートコンプリートにリストを表示させるためにUIを再起動したくない場合に、リストを再構築するために使用できます。

|

||||

|

||||

また、この設定をクイック設定バーに追加することで、いつでも更新ボタンを利用できるようになります。

|

||||

|

||||

|

||||

</details>

|

||||

<br/>

|

||||

|

||||

# 翻訳

|

||||

タグとエイリアスの両方を翻訳するために使用することができ、また翻訳による検索を可能にするための、追加のファイルを翻訳セクションに追加することができます。

|

||||

このファイルは、`<英語のタグ/エイリアス>,<翻訳>`という形式のCSVである必要がありますが、3列のフォーマットを使用する古いファイルとの後方互換性のために、`oldFormat`をオンにすると代わりにそれを使うことができます。

|

||||

このファイルは、`<English tag/alias>,<Translation>`という形式のCSVである必要がありますが、3列のフォーマットを使用する古いファイルとの後方互換性のために、`oldFormat`をオンにすると、代わりに新しい2列の翻訳形式ではなく、古い3列の翻訳形式を使用するようになります。

|

||||

その場合、2番目のカラムは使用されず、パース時にスキップされます。

|

||||

|

||||

中国語の翻訳例:

|

||||

|

||||

|

||||

|

||||

|

||||

#### Extra file

|

||||

## 翻訳リスト

|

||||

- [🇨🇳 Chinese tags](https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/discussions/23) by @HalfMAI, 最も一般的なタグを機械翻訳と手作業で修正(レガシーフォーマットを使用)

|

||||

- [🇨🇳 Chinese tags](https://github.com/sgmklp/tag-for-autocompletion-with-translation) by @sgmklp, [こちら](https://github.com/zcyzcy88/TagTable)をベースにして、より小さくした手動での翻訳セット。

|

||||

|

||||

> ### 🫵 あなたの助けが必要です!

|

||||

> 翻訳はコミュニティの努力により支えられています。もしあなたがタグファイルを翻訳したことがある場合、または作成したい場合は、あなたの成果をここに追加できるように、Pull RequestまたはIssueを開いてください。

|

||||

> 機械翻訳は、最も一般的なタグであっても、多くのことを間違えてしまいます。

|

||||

|

||||

## ライブ・プレビュー

|

||||

> ⚠️ 警告:

|

||||

>

|

||||

> この機能はまだ実験的なもので、使用中にバグに遭遇するかもしれません。

|

||||

|

||||

この機能はプロンプト内のすべての検出されたタグのライブプレビューを表示します。検出されたタグは、カンマで正しく区切られたものと長い文章の中にあるものの両方が表示されます。自然な文章では3単語まで検出することができ、1つのタグよりも複数単語の完全な一致を優先します。

|

||||

|

||||

検出されたタグの上には翻訳ファイルからの訳文が表示されるので、英語のタグの意味がよく分からない場合でも、プロンプトにタグが挿入された後でも(完了時のポップアップではなく)簡単に見つけることができます。

|

||||

|

||||

このオプションはデフォルトではオフになっていますが、翻訳ファイルを選択し、「Show live tag translation below prompt」をチェックすることで有効にすることができます。

|

||||

オフでも通常の機能には影響しません。

|

||||

|

||||

中国語翻訳時の例:

|

||||

|

||||

|

||||

|

||||

検出されたタグをクリックすると、そのタグがプロンプトで選択され、素早く編集できます。

|

||||

|

||||

|

||||

|

||||

#### ⚠️ ライブ翻訳に関する確認されている問題:

|

||||

ユーザーがテキストを入力または貼り付けると翻訳が更新されますが、プログラムによる操作(スタイルの適用やPNG Info / Image Browserからの読み込みなど)では更新されません。これは、プログラムによる編集の後に手動で何かを入力することで回避できます。

|

||||

|

||||

# Extra file

|

||||

エクストラファイルは、メインセットに含まれない新しいタグやカスタムタグを追加するために使用されます。

|

||||

[CSV tag data](#csv-tag-data)にある通常のタグのフォーマットと同じですが、ひとつだけ例外があります:

|

||||

カスタムタグにはカウントがないため、3列目(0から数える場合は2列目)はタグの横に表示される灰色のメタテキストに使用されます。

|

||||

@@ -213,7 +452,7 @@ Booruのサイトのように、タグは1つまたは複数のエイリアス

|

||||

|

||||

カスタムタグを通常のタグの前に追加するか、後に追加するかは、設定で選択することができます。

|

||||

|

||||

## CSV tag data

|

||||

# CSV tag data

|

||||

このスクリプトは、以下の方法で保存されたタグ付きCSVファイルを想定しています:

|

||||

```csv

|

||||

<name>,<type>,<postCount>,"<aliases>"

|

||||

@@ -252,3 +491,32 @@ commentary_request,5,2610959,

|

||||

|8 | Lore |

|

||||

|

||||

タグの種類は、結果の一覧のエントリーの色付けに使用されます。

|

||||

|

||||

## ⚠️ よくある問題、また現在確認されている問題:

|

||||

- お使いのブラウザの設定によっては、古いバージョンのスクリプトがキャッシュされることがあります。例えば、アップデート後に新機能が表示されない場合は、キャッシュを使わずにサイトを強制的にリロードするために、

|

||||

<kbd>CTRL</kbd> + <kbd>F5</kbd>

|

||||

を試してください。

|

||||

- プロンプトのポップアップが壊れたスタイルで表示されるか、全く表示されない場合([このような場合](https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/assets/34448969/7bbfdd54-fc23-4bfc-85af-24704b139b3a))、openpose-editor 拡張機能がインストールされている場合は更新してください。古いバージョンでは他の拡張機能との間で問題が生じることが知られています。

|

||||

|

||||

<!-- Variable declarations for shorter main text -->

|

||||

[release-shield]: https://img.shields.io/github/v/release/DominikDoom/a1111-sd-webui-tagcomplete?logo=github&style=

|

||||

[release-url]: https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/releases

|

||||

|

||||

[contributors-shield]: https://img.shields.io/github/contributors/DominikDoom/a1111-sd-webui-tagcomplete

|

||||

[contributors-url]: https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/graphs/contributors

|

||||

|

||||

[forks-shield]: https://img.shields.io/github/forks/DominikDoom/a1111-sd-webui-tagcomplete

|

||||

[forks-url]: https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/network/members

|

||||

|

||||

[stargazers-shield]: https://img.shields.io/github/stars/DominikDoom/a1111-sd-webui-tagcomplete

|

||||

[stargazers-url]: https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/stargazers

|

||||

|

||||

[issues-shield]: https://img.shields.io/github/issues/DominikDoom/a1111-sd-webui-tagcomplete

|

||||

[issues-url]: https://github.com/DominikDoom/a1111-sd-webui-tagcomplete/issues/new/choose

|

||||

|

||||

<!-- Links for feature section -->

|

||||

[image-browser-url]: https://github.com/AlUlkesh/stable-diffusion-webui-images-browser

|

||||

[multidiffusion-url]: https://github.com/pkuliyi2015/multidiffusion-upscaler-for-automatic1111

|

||||

[tag-editor-url]: https://github.com/toshiaki1729/stable-diffusion-webui-dataset-tag-editor

|

||||

[wd-tagger-url]: https://github.com/toriato/stable-diffusion-webui-wd14-tagger

|

||||

[umi-url]: https://github.com/Klokinator/Umi-AI

|

||||

|

||||

@@ -1,6 +1,7 @@

|

||||

// Core components

|

||||

var TAC_CFG = null;

|

||||

var tagBasePath = "";

|

||||

var modelKeywordPath = "";

|

||||

|

||||

// Tag completion data loaded from files

|

||||

var allTags = [];

|

||||

@@ -10,10 +11,12 @@ var extras = [];

|

||||

var wildcardFiles = [];

|

||||

var wildcardExtFiles = [];

|

||||

var yamlWildcards = [];

|

||||

var umiWildcards = [];

|

||||

var embeddings = [];

|

||||

var hypernetworks = [];

|

||||

var loras = [];

|

||||

var lycos = [];

|

||||

var modelKeywordDict = new Map();

|

||||

var chants = [];

|

||||

|

||||

// Selected model info for black/whitelisting

|

||||

@@ -34,6 +37,12 @@ let hideBlocked = false;

|

||||

var selectedTag = null;

|

||||

var oldSelectedTag = null;

|

||||

|

||||

// Lora keyword undo/redo history

|

||||

var textBeforeKeywordInsertion = "";

|

||||

var textAfterKeywordInsertion = "";

|

||||

var lastEditWasKeywordInsertion = false;

|

||||

var keywordInsertionUndone = false;

|

||||

|

||||

// UMI

|

||||

var umiPreviousTags = [];

|

||||

|

||||

|

||||

@@ -8,10 +8,11 @@ const ResultType = Object.freeze({

|

||||

"wildcardTag": 4,

|

||||

"wildcardFile": 5,

|

||||

"yamlWildcard": 6,

|

||||

"hypernetwork": 7,

|

||||

"lora": 8,

|

||||

"lyco": 9,

|

||||

"chant": 10

|

||||

"umiWildcard": 7,

|

||||

"hypernetwork": 8,

|

||||

"lora": 9,

|

||||

"lyco": 10,

|

||||

"chant": 11

|

||||

});

|

||||

|

||||

// Class to hold result data and annotations to make it clearer to use

|

||||

@@ -25,6 +26,7 @@ class AutocompleteResult {

|

||||

count = null;

|

||||

aliases = null;

|

||||

meta = null;

|

||||

hash = null;

|

||||

|

||||

// Constructor

|

||||

constructor(text, type) {

|

||||

|

||||

@@ -61,6 +61,26 @@ async function loadCSV(path) {

|

||||

return parseCSV(text);

|

||||

}

|

||||

|

||||

// Fetch API

|

||||

async function fetchAPI(url, json = true, cache = false) {

|

||||

if (!cache) {

|

||||

const appendChar = url.includes("?") ? "&" : "?";

|

||||

url += `${appendChar}${new Date().getTime()}`

|

||||

}

|

||||

|

||||

let response = await fetch(url);

|

||||

|

||||

if (response.status != 200) {

|

||||

console.error(`Error fetching API endpoint "${url}": ` + response.status, response.statusText);

|

||||

return null;

|

||||

}

|

||||

|

||||

if (json)

|

||||

return await response.json();

|

||||

else

|

||||

return await response.text();

|

||||

}

|

||||

|

||||

// Debounce function to prevent spamming the autocomplete function

|

||||

var dbTimeOut;

|

||||

const debounce = (func, wait = 300) => {

|

||||

@@ -89,6 +109,28 @@ function difference(a, b) {

|

||||

)].reduce((acc, [v, count]) => acc.concat(Array(Math.abs(count)).fill(v)), []);

|

||||

}

|

||||

|

||||

// Object flatten function adapted from https://stackoverflow.com/a/61602592

|

||||

// $roots keeps previous parent properties as they will be added as a prefix for each prop.

|

||||

// $sep is just a preference if you want to seperate nested paths other than dot.

|

||||

function flatten(obj, roots = [], sep = ".") {

|

||||

return Object.keys(obj).reduce(

|

||||

(memo, prop) =>

|

||||

Object.assign(

|

||||

// create a new object

|

||||

{},

|

||||

// include previously returned object

|

||||

memo,

|

||||

Object.prototype.toString.call(obj[prop]) === "[object Object]"

|

||||

? // keep working if value is an object

|

||||

flatten(obj[prop], roots.concat([prop]), sep)

|

||||

: // include current prop and value and prefix prop with the roots

|

||||

{ [roots.concat([prop]).join(sep)]: obj[prop] }

|

||||

),

|

||||

{}

|

||||

);

|

||||

}

|

||||

|

||||

|

||||

// Sliding window function to get possible combination groups of an array

|

||||

function toNgrams(inputArray, size) {

|

||||

return Array.from(

|

||||

|

||||

@@ -8,7 +8,7 @@ class LoraParser extends BaseTagParser {

|

||||

if (tagword !== "<" && tagword !== "<l:" && tagword !== "<lora:") {

|

||||

let searchTerm = tagword.replace("<lora:", "").replace("<l:", "").replace("<", "");

|

||||

let filterCondition = x => x.toLowerCase().includes(searchTerm) || x.toLowerCase().replaceAll(" ", "_").includes(searchTerm);

|

||||

tempResults = loras.filter(x => filterCondition(x)); // Filter by tagword

|

||||

tempResults = loras.filter(x => filterCondition(x[0])); // Filter by tagword

|

||||

} else {

|

||||

tempResults = loras;

|

||||

}

|

||||

@@ -16,8 +16,9 @@ class LoraParser extends BaseTagParser {

|

||||

// Add final results

|

||||

let finalResults = [];

|

||||

tempResults.forEach(t => {

|

||||

let result = new AutocompleteResult(t.trim(), ResultType.lora)

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.lora)

|

||||

result.meta = "Lora";

|

||||

result.hash = t[1];

|

||||

finalResults.push(result);

|

||||

});

|

||||

|

||||

@@ -28,18 +29,28 @@ class LoraParser extends BaseTagParser {

|

||||

async function load() {

|

||||

if (loras.length === 0) {

|

||||

try {

|

||||

loras = (await readFile(`${tagBasePath}/temp/lora.txt`)).split("\n")

|

||||

.filter(x => x.trim().length > 0) // Remove empty lines

|

||||

.map(x => x.trim()); // Remove carriage returns and padding if it exists

|

||||

loras = (await loadCSV(`${tagBasePath}/temp/lora.txt`))

|

||||

.filter(x => x[0]?.trim().length > 0) // Remove empty lines

|

||||

.map(x => [x[0]?.trim(), x[1]]); // Trim filenames and return the name, hash pairs

|

||||

} catch (e) {

|

||||

console.error("Error loading lora.txt: " + e);

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

function sanitize(tagType, text) {

|

||||

async function sanitize(tagType, text) {

|

||||

if (tagType === ResultType.lora) {

|

||||

return `<lora:${text}:${TAC_CFG.extraNetworksDefaultMultiplier}>`;

|

||||

let multiplier = TAC_CFG.extraNetworksDefaultMultiplier;

|

||||

let info = await fetchAPI(`tacapi/v1/lora-info/${text}`)

|

||||

if (info && info["preferred weight"]) {

|

||||

multiplier = info["preferred weight"];

|

||||

}

|

||||

|

||||

const lastDot = text.lastIndexOf(".");

|

||||

const lastSlash = text.lastIndexOf("/");

|

||||

const name = text.substring(lastSlash + 1, lastDot);

|

||||

|

||||

return `<lora:${name}:${multiplier}>`;

|

||||

}

|

||||

return null;

|

||||

}

|

||||

|

||||

@@ -8,7 +8,7 @@ class LycoParser extends BaseTagParser {

|

||||

if (tagword !== "<" && tagword !== "<l:" && tagword !== "<lyco:") {

|

||||

let searchTerm = tagword.replace("<lyco:", "").replace("<l:", "").replace("<", "");

|

||||

let filterCondition = x => x.toLowerCase().includes(searchTerm) || x.toLowerCase().replaceAll(" ", "_").includes(searchTerm);

|

||||

tempResults = lycos.filter(x => filterCondition(x)); // Filter by tagword

|

||||

tempResults = lycos.filter(x => filterCondition(x[0])); // Filter by tagword

|

||||

} else {

|

||||

tempResults = lycos;

|

||||

}

|

||||

@@ -16,8 +16,9 @@ class LycoParser extends BaseTagParser {

|

||||

// Add final results

|

||||

let finalResults = [];

|

||||

tempResults.forEach(t => {

|

||||

let result = new AutocompleteResult(t.trim(), ResultType.lyco)

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.lyco)

|

||||

result.meta = "Lyco";

|

||||

result.hash = t[1];

|

||||

finalResults.push(result);

|

||||

});

|

||||

|

||||

@@ -28,18 +29,28 @@ class LycoParser extends BaseTagParser {

|

||||

async function load() {

|

||||

if (lycos.length === 0) {

|

||||

try {

|

||||

lycos = (await readFile(`${tagBasePath}/temp/lyco.txt`)).split("\n")

|

||||

.filter(x => x.trim().length > 0) // Remove empty lines

|

||||

.map(x => x.trim()); // Remove carriage returns and padding if it exists

|

||||

lycos = (await loadCSV(`${tagBasePath}/temp/lyco.txt`))

|

||||

.filter(x => x[0]?.trim().length > 0) // Remove empty lines

|

||||

.map(x => [x[0]?.trim(), x[1]]); // Trim filenames and return the name, hash pairs

|

||||

} catch (e) {

|

||||

console.error("Error loading lyco.txt: " + e);

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

function sanitize(tagType, text) {

|

||||

async function sanitize(tagType, text) {

|

||||

if (tagType === ResultType.lyco) {

|

||||

return `<lyco:${text}:${TAC_CFG.extraNetworksDefaultMultiplier}>`;

|

||||

let multiplier = TAC_CFG.extraNetworksDefaultMultiplier;

|

||||

let info = await fetchAPI(`tacapi/v1/lyco-info/${text}`)

|

||||

if (info && info["preferred weight"]) {

|

||||

multiplier = info["preferred weight"];

|

||||

}

|

||||

|

||||

const lastDot = text.lastIndexOf(".");

|

||||

const lastSlash = text.lastIndexOf("/");

|

||||

const name = text.substring(lastSlash + 1, lastDot);

|

||||

|

||||

return `<lyco:${name}:${multiplier}>`;

|

||||

}

|

||||

return null;

|

||||

}

|

||||

|

||||

42

javascript/ext_modelKeyword.js

Normal file

42

javascript/ext_modelKeyword.js

Normal file

@@ -0,0 +1,42 @@

|

||||

async function load() {

|

||||

let modelKeywordParts = (await readFile(`tmp/modelKeywordPath.txt`)).split(",")

|

||||

modelKeywordPath = modelKeywordParts[0];

|

||||

let customFileExists = modelKeywordParts[1] === "True";

|

||||

|

||||

if (modelKeywordPath.length > 0 && modelKeywordDict.size === 0) {

|

||||

try {

|

||||

let csv_lines = [];

|

||||

// Only add default keywords if wanted by the user

|

||||

if (TAC_CFG.modelKeywordCompletion !== "Only user list")

|

||||

csv_lines = (await loadCSV(`${modelKeywordPath}/lora-keyword.txt`));

|

||||

// Add custom user keywords if the file exists

|

||||

if (customFileExists)

|

||||

csv_lines = csv_lines.concat((await loadCSV(`${modelKeywordPath}/lora-keyword-user.txt`)));

|

||||

|

||||

if (csv_lines.length === 0) return;

|

||||

|

||||

csv_lines = csv_lines.filter(x => x[0].trim().length > 0 && x[0].trim()[0] !== "#") // Remove empty lines and comments

|

||||

|

||||

// Add to the dict

|

||||

csv_lines.forEach(parts => {

|

||||

const hash = parts[0];

|

||||

const keywords = parts[1].replaceAll("| ", ", ").replaceAll("|", ", ").trim();

|

||||

const lastSepIndex = parts[2]?.lastIndexOf("/") + 1 || parts[2]?.lastIndexOf("\\") + 1 || 0;

|

||||

const name = parts[2]?.substring(lastSepIndex).trim() || "none"

|

||||

|

||||

if (modelKeywordDict.has(hash) && name !== "none") {

|

||||

// Add a new name key if the hash already exists

|

||||

modelKeywordDict.get(hash).set(name, keywords);

|

||||

} else {

|

||||

// Create new hash entry

|

||||

let map = new Map().set(name, keywords);

|

||||

modelKeywordDict.set(hash, map);

|

||||

}

|

||||

});

|

||||

} catch (e) {

|

||||

console.error("Error loading model-keywords list: " + e);

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

QUEUE_FILE_LOAD.push(load);

|

||||

@@ -74,7 +74,7 @@ class UmiParser extends BaseTagParser {

|

||||

//console.log({ matches })

|

||||

|

||||

const filteredWildcards = (tagword) => {

|

||||

const wildcards = yamlWildcards.filter(x => {

|

||||

const wildcards = umiWildcards.filter(x => {

|

||||

let tags = x[1];

|

||||

const matchesNeg =

|

||||

matches.negative.length === 0

|

||||

@@ -144,7 +144,7 @@ class UmiParser extends BaseTagParser {

|

||||

// Add final results

|

||||

let finalResults = [];

|

||||

tempResults.forEach(t => {

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.yamlWildcard)

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.umiWildcard)

|

||||

result.count = t[1];

|

||||

finalResults.push(result);

|

||||

});

|

||||

@@ -156,7 +156,7 @@ class UmiParser extends BaseTagParser {

|

||||

// Add final results

|

||||

let finalResults = [];

|

||||

filteredWildcardsSorted.forEach(t => {

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.yamlWildcard)

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.umiWildcard)

|

||||

result.count = t[1];

|

||||

finalResults.push(result);

|

||||

});

|

||||

@@ -171,7 +171,7 @@ class UmiParser extends BaseTagParser {

|

||||

// Add final results

|

||||

let finalResults = [];

|

||||

filteredWildcardsSorted.forEach(t => {

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.yamlWildcard)

|

||||

let result = new AutocompleteResult(t[0].trim(), ResultType.umiWildcard)

|

||||

result.count = t[1];

|

||||

finalResults.push(result);

|

||||

});

|

||||

@@ -184,8 +184,8 @@ class UmiParser extends BaseTagParser {

|

||||

}

|

||||

|

||||

function updateUmiTags( tagType, sanitizedText, newPrompt, textArea) {

|

||||

// If it was a yaml wildcard, also update the umiPreviousTags

|

||||

if (tagType === ResultType.yamlWildcard && originalTagword.length > 0) {

|

||||

// If it was a umi wildcard, also update the umiPreviousTags

|

||||

if (tagType === ResultType.umiWildcard && originalTagword.length > 0) {

|

||||

let umiSubPrompts = [...newPrompt.matchAll(UMI_PROMPT_REGEX)];

|

||||

|

||||

let umiTags = [];

|

||||

@@ -203,11 +203,11 @@ function updateUmiTags( tagType, sanitizedText, newPrompt, textArea) {

|

||||

}

|

||||

|

||||

async function load() {

|

||||

if (yamlWildcards.length === 0) {

|

||||

if (umiWildcards.length === 0) {

|

||||

try {

|

||||

let yamlTags = (await readFile(`${tagBasePath}/temp/wcet.txt`)).split("\n");

|

||||

let umiTags = (await readFile(`${tagBasePath}/temp/umi_tags.txt`)).split("\n");

|

||||

// Split into tag, count pairs

|

||||

yamlWildcards = yamlTags.map(x => x

|

||||

umiWildcards = umiTags.map(x => x

|

||||

.trim()

|

||||

.split(","))

|

||||

.map(([i, ...rest]) => [

|

||||

@@ -218,14 +218,14 @@ async function load() {

|

||||

}, {}),

|

||||

]);

|

||||

} catch (e) {

|

||||

console.error("Error loading yaml wildcards: " + e);

|

||||

console.error("Error loading umi wildcards: " + e);

|

||||

}

|

||||

}

|

||||

}

|

||||

|

||||

function sanitize(tagType, text) {

|

||||

// Replace underscores only if the yaml tag is not using them

|

||||

if (tagType === ResultType.yamlWildcard && !yamlWildcards.includes(text)) {

|

||||

// Replace underscores only if the umi tag is not using them

|

||||

if (tagType === ResultType.umiWildcard && !umiWildcards.includes(text)) {

|

||||

return text.replaceAll("_", " ");

|

||||

}

|

||||

return null;

|

||||

|

||||

@@ -13,12 +13,35 @@ class WildcardParser extends BaseTagParser {

|

||||

let wcWord = wcMatch[0][2];

|

||||

|

||||

// Look in normal wildcard files

|

||||

let wcFound = wildcardFiles.find(x => x[1].toLowerCase() === wcFile);

|

||||

let wcFound = wildcardFiles.filter(x => x[1].toLowerCase() === wcFile);

|

||||

if (wcFound.length === 0) wcFound = null;

|

||||

// Use found wildcard file or look in external wildcard files

|

||||

let wcPair = wcFound || wildcardExtFiles.find(x => x[1].toLowerCase() === wcFile);

|

||||

let wcPairs = wcFound || wildcardExtFiles.filter(x => x[1].toLowerCase() === wcFile);

|

||||

|

||||

let wildcards = (await readFile(`${wcPair[0]}/${wcPair[1]}.txt`)).split("\n")

|

||||

.filter(x => x.trim().length > 0 && !x.startsWith('#')); // Remove empty lines and comments

|

||||

if (!wcPairs) return [];

|

||||

|

||||

let wildcards = [];

|

||||

for (let i = 0; i < wcPairs.length; i++) {

|

||||

const wcPair = wcPairs[i];

|

||||

if (!wcPair[0] || !wcPair[1]) continue;

|

||||

|

||||

if (wcPair[0].endsWith(".yaml")) {

|

||||

const getDescendantProp = (obj, desc) => {

|

||||

const arr = desc.split("/");

|

||||

while (arr.length) {

|

||||

obj = obj[arr.shift()];

|

||||

}

|

||||

return obj;

|

||||

}

|

||||

wildcards = wildcards.concat(getDescendantProp(yamlWildcards[wcPair[0]], wcPair[1]));

|

||||

} else {

|

||||

const fileContent = (await readFile(`${wcPair[0]}/${wcPair[1]}.txt`)).split("\n")

|

||||

.filter(x => x.trim().length > 0 && !x.startsWith('#')); // Remove empty lines and comments

|

||||

wildcards = wildcards.concat(fileContent);

|

||||

}

|

||||

}

|

||||

|

||||

wildcards.sort((a, b) => a.localeCompare(b));

|

||||

|

||||

let finalResults = [];

|

||||

let tempResults = wildcards.filter(x => (wcWord !== null && wcWord.length > 0) ? x.toLowerCase().includes(wcWord) : x) // Filter by tagword

|

||||

@@ -44,13 +67,27 @@ class WildcardFileParser extends BaseTagParser {

|

||||

}

|

||||

|

||||

let finalResults = [];

|

||||

const alreadyAdded = new Map();

|

||||

// Get final results

|

||||

tempResults.forEach(wcFile => {

|

||||

let result = new AutocompleteResult(wcFile[1].trim(), ResultType.wildcardFile);

|

||||

result.meta = "Wildcard file";

|

||||

// Skip duplicate entries incase multiple files have the same name or yaml category

|

||||

if (alreadyAdded.has(wcFile[1])) return;

|

||||

|

||||

let result = null;

|

||||

if (wcFile[0].endsWith(".yaml")) {

|

||||

result = new AutocompleteResult(wcFile[1].trim(), ResultType.yamlWildcard);

|

||||

result.meta = "YAML wildcard collection";

|

||||

} else {

|

||||

result = new AutocompleteResult(wcFile[1].trim(), ResultType.wildcardFile);

|

||||

result.meta = "Wildcard file";

|

||||

}

|

||||

|

||||

finalResults.push(result);

|

||||

alreadyAdded.set(wcFile[1], true);

|

||||

});

|

||||

|

||||

finalResults.sort((a, b) => a.text.localeCompare(b.text));

|

||||

|

||||

return finalResults;

|

||||

}

|

||||

}

|

||||

@@ -87,6 +124,17 @@ async function load() {

|

||||

wcExtFile = wcExtFile.map(x => [base, x]);

|

||||

wildcardExtFiles.push(...wcExtFile);

|

||||

}

|

||||

|

||||

// Load the yaml wildcard json file and append it as a wildcard file, appending each key as a path component until we reach the end

|

||||

yamlWildcards = await readFile(`${tagBasePath}/temp/wc_yaml.json`, true);

|

||||

|

||||

// Append each key as a path component until we reach a leaf

|

||||

Object.keys(yamlWildcards).forEach(file => {

|

||||

const flattened = flatten(yamlWildcards[file], [], "/");

|

||||

Object.keys(flattened).forEach(key => {

|

||||

wildcardExtFiles.push([file, key]);

|

||||

});

|

||||

});

|

||||

} catch (e) {

|

||||

console.error("Error loading wildcards: " + e);

|

||||

}

|

||||

@@ -94,7 +142,7 @@ async function load() {

|

||||

}

|

||||

|

||||

function sanitize(tagType, text) {

|

||||

if (tagType === ResultType.wildcardFile) {

|

||||

if (tagType === ResultType.wildcardFile || tagType === ResultType.yamlWildcard) {

|

||||

return `__${text}__`;

|

||||

} else if (tagType === ResultType.wildcardTag) {

|

||||

return text.replace(/^.*?: /g, "");

|

||||

@@ -104,7 +152,7 @@ function sanitize(tagType, text) {

|

||||

|

||||

function keepOpenIfWildcard(tagType, sanitizedText, newPrompt, textArea) {

|

||||

// If it's a wildcard, we want to keep the results open so the user can select another wildcard

|

||||

if (tagType === ResultType.wildcardFile) {

|

||||

if (tagType === ResultType.wildcardFile || tagType === ResultType.yamlWildcard) {

|

||||

hideBlocked = true;

|

||||

autocomplete(textArea, newPrompt, sanitizedText);

|

||||

setTimeout(() => { hideBlocked = false; }, 450);

|

||||

|

||||

@@ -199,7 +199,10 @@ async function syncOptions() {

|

||||

replaceUnderscores: opts["tac_replaceUnderscores"],

|

||||

escapeParentheses: opts["tac_escapeParentheses"],

|

||||

appendComma: opts["tac_appendComma"],

|

||||

appendSpace: opts["tac_appendSpace"],

|

||||

alwaysSpaceAtEnd: opts["tac_alwaysSpaceAtEnd"],

|

||||

wildcardCompletionMode: opts["tac_wildcardCompletionMode"],

|

||||

modelKeywordCompletion: opts["tac_modelKeywordCompletion"],

|

||||

// Alias settings

|

||||

alias: {

|

||||

searchByAlias: opts["tac_alias.searchByAlias"],

|

||||

@@ -372,7 +375,7 @@ async function insertTextAtCursor(textArea, result, tagword, tabCompletedWithout

|

||||

}

|

||||

}

|

||||

|

||||

if (tagType === ResultType.wildcardFile

|

||||

if ((tagType === ResultType.wildcardFile || tagType === ResultType.yamlWildcard)

|

||||

&& tabCompletedWithoutChoice

|

||||

&& TAC_CFG.wildcardCompletionMode !== "Always fully"

|

||||

&& sanitizedText.includes("/")) {

|

||||

@@ -399,9 +402,11 @@ async function insertTextAtCursor(textArea, result, tagword, tabCompletedWithout

|

||||

}

|

||||

}

|

||||

// Don't cut off the __ at the end if it is already the full path

|

||||

if (firstDifference < longestResult) {

|

||||

if (firstDifference > 0 && firstDifference < longestResult) {

|

||||

// +2 because the sanitized text already has the __ at the start but the matched text doesn't

|

||||

sanitizedText = sanitizedText.substring(0, firstDifference + 2);

|

||||

} else if (firstDifference === 0) {

|

||||

sanitizedText = tagword;

|

||||

}

|

||||

}

|

||||

}

|

||||

@@ -417,9 +422,18 @@ async function insertTextAtCursor(textArea, result, tagword, tabCompletedWithout

|

||||

|

||||

var optionalSeparator = "";

|

||||

let extraNetworkTypes = [ResultType.hypernetwork, ResultType.lora];

|

||||

let noCommaTypes = [ResultType.wildcardFile, ResultType.yamlWildcard].concat(extraNetworkTypes);

|

||||

if (TAC_CFG.appendComma && !noCommaTypes.includes(tagType)) {

|

||||

optionalSeparator = surrounding.match(new RegExp(`${escapeRegExp(tagword)}[,:]`, "i")) !== null ? "" : ", ";

|

||||

let noCommaTypes = [ResultType.wildcardFile, ResultType.yamlWildcard, ResultType.umiWildcard].concat(extraNetworkTypes);

|

||||

if (!noCommaTypes.includes(tagType)) {

|

||||

// Append comma if enabled and not already present

|

||||

let beforeComma = surrounding.match(new RegExp(`${escapeRegExp(tagword)}[,:]`, "i")) !== null;

|

||||

if (TAC_CFG.appendComma)

|

||||

optionalSeparator = beforeComma ? "" : ",";

|

||||

// Add space if enabled

|

||||

if (TAC_CFG.appendSpace && !beforeComma)

|

||||

optionalSeparator += " ";

|

||||

// If at end of prompt and enabled, override the normal setting if not already added

|

||||

if (!TAC_CFG.appendSpace && TAC_CFG.alwaysSpaceAtEnd)

|

||||

optionalSeparator += surrounding.match(new RegExp(`${escapeRegExp(tagword)}$`, "im")) !== null ? " " : "";

|

||||

} else if (extraNetworkTypes.includes(tagType)) {

|

||||

// Use the dedicated separator for extra networks if it's defined, otherwise fall back to space

|

||||

optionalSeparator = TAC_CFG.extraNetworksSeparator || " ";

|

||||

@@ -430,8 +444,54 @@ async function insertTextAtCursor(textArea, result, tagword, tabCompletedWithout

|

||||

|

||||

// Add back start

|

||||

var newPrompt = prompt.substring(0, editStart) + insert + prompt.substring(editEnd);

|

||||

|

||||

// Add lora/lyco keywords if enabled and found

|

||||

let keywordsLength = 0;

|

||||

|

||||

if (TAC_CFG.modelKeywordCompletion !== "Never" && (tagType === ResultType.lora || tagType === ResultType.lyco)) {

|

||||

let keywords = null;

|

||||

// Check built-in activation words first

|

||||

if (tagType === ResultType.lora || tagType === ResultType.lyco) {

|

||||

let info = await fetchAPI(`tacapi/v1/lora-info/${result.text}`)

|

||||

if (info && info["activation text"]) {

|

||||

keywords = info["activation text"];

|

||||

}

|

||||

}

|

||||

|

||||

if (!keywords && modelKeywordPath.length > 0 && result.hash && result.hash !== "NOFILE" && result.hash.length > 0) {

|

||||

let nameDict = modelKeywordDict.get(result.hash);

|

||||

let names = [result.text + ".safetensors", result.text + ".pt", result.text + ".ckpt"];

|

||||

|

||||

if (nameDict) {

|

||||

let found = false;

|

||||

names.forEach(name => {

|

||||

if (!found && nameDict.has(name)) {

|

||||

found = true;

|

||||

keywords = nameDict.get(name);

|

||||

}

|

||||

});

|

||||

|

||||

if (!found)

|

||||

keywords = nameDict.get("none");

|

||||

}

|

||||

}

|

||||

|

||||

if (keywords && keywords.length > 0) {

|

||||

textBeforeKeywordInsertion = newPrompt;

|

||||

|

||||

newPrompt = `${keywords}, ${newPrompt}`; // Insert keywords

|

||||

|

||||

textAfterKeywordInsertion = newPrompt;

|

||||

keywordInsertionUndone = false;

|

||||

setTimeout(() => lastEditWasKeywordInsertion = true, 200)

|

||||

|

||||

keywordsLength = keywords.length + 2; // +2 for the comma and space

|

||||

}

|

||||

}

|

||||

|

||||

// Insert into prompt textbox and reposition cursor

|

||||

textArea.value = newPrompt;

|

||||

textArea.selectionStart = afterInsertCursorPos + optionalSeparator.length;

|

||||

textArea.selectionStart = afterInsertCursorPos + optionalSeparator.length + keywordsLength;

|

||||

textArea.selectionEnd = textArea.selectionStart

|

||||

|

||||

// Since we've modified a Gradio Textbox component manually, we need to simulate an `input` DOM event to ensure it's propagated back to python.

|

||||

@@ -523,6 +583,11 @@ function addResultsToList(textArea, results, tagword, resetList) {

|

||||

|

||||

if (!TAC_CFG.alias.onlyShowAlias && result.text !== bestAlias)

|

||||

displayText += " ➝ " + result.text;

|

||||

} else if (result.type === ResultType.lora || result.type === ResultType.lyco) {

|

||||

let lastDot = result.text.lastIndexOf(".");

|

||||

let lastSlash = result.text.lastIndexOf("/");

|

||||

let name = result.text.substring(lastSlash + 1, lastDot);

|

||||

displayText = escapeHTML(name);

|

||||

} else { // No alias

|

||||

displayText = escapeHTML(result.text);

|

||||

}

|

||||

@@ -534,7 +599,8 @@ function addResultsToList(textArea, results, tagword, resetList) {

|

||||

// Print search term bolded in result

|

||||

itemText.innerHTML = displayText.replace(tagword, `<b>${tagword}</b>`);

|

||||

|

||||

if (result.type === ResultType.wildcardFile && itemText.innerHTML.includes("/")) {

|

||||

const splitTypes = [ResultType.wildcardFile, ResultType.yamlWildcard]

|

||||

if (splitTypes.includes(result.type) && itemText.innerHTML.includes("/")) {

|

||||

let parts = itemText.innerHTML.split("/");

|

||||

let lastPart = parts[parts.length - 1];

|

||||

parts = parts.slice(0, parts.length - 1);

|

||||

@@ -760,6 +826,37 @@ function rubyTagClicked(node, textBefore, prompt, textArea) {

|

||||

textArea.setSelectionRange(startPos, endPos);

|

||||

}

|

||||

|

||||

// Check if the last edit was the keyword insertion, and catch undo/redo in that case

|

||||

function checkKeywordInsertionUndo(textArea, event) {

|

||||

if (TAC_CFG.modelKeywordCompletion === "Never") return;

|

||||

|

||||

switch (event.inputType) {

|

||||

case "historyUndo":

|

||||

if (lastEditWasKeywordInsertion && !keywordInsertionUndone) {

|

||||

keywordInsertionUndone = true;

|

||||

textArea.value = textBeforeKeywordInsertion;

|

||||

updateInput(textArea);

|

||||

}

|

||||

break;

|

||||

case "historyRedo":

|

||||

if (lastEditWasKeywordInsertion && keywordInsertionUndone) {

|

||||

keywordInsertionUndone = false;

|

||||

textArea.value = textAfterKeywordInsertion;

|

||||

updateInput(textArea);

|

||||

}

|

||||

case undefined:

|

||||

// undefined is caused by the updateInput event firing, so we just ignore it

|

||||

break;

|

||||

default:

|

||||

// Everything else deactivates the keyword undo and returns to normal undo behavior

|

||||

lastEditWasKeywordInsertion = false;

|

||||

keywordInsertionUndone = false;

|

||||

textBeforeKeywordInsertion = "";

|

||||

textAfterKeywordInsertion = "";

|

||||

break;

|

||||

}

|

||||

}

|

||||

|

||||

async function autocomplete(textArea, prompt, fixedTag = null) {

|

||||

// Return if the function is deactivated in the UI

|

||||

if (!isEnabled()) return;

|

||||

@@ -1020,11 +1117,12 @@ async function refreshTacTempFiles() {

|

||||

setTimeout(async () => {

|

||||

wildcardFiles = [];

|

||||

wildcardExtFiles = [];

|

||||

yamlWildcards = [];

|

||||

umiWildcards = [];

|

||||

embeddings = [];

|

||||

hypernetworks = [];

|

||||

loras = [];

|

||||

lycos = [];

|

||||

modelKeywordDict.clear();

|

||||

await processQueue(QUEUE_FILE_LOAD, null);

|

||||

|

||||

console.log("TAC: Refreshed temp files");

|

||||

@@ -1050,9 +1148,10 @@ function addAutocompleteToArea(area) {

|

||||

hideResults(area);

|

||||

|

||||

// Add autocomplete event listener

|

||||

area.addEventListener('input', () => {

|

||||

area.addEventListener('input', (e) => {

|

||||

debounce(autocomplete(area, area.value), TAC_CFG.delayTime);

|

||||

updateRuby(area, area.value);

|